OpenAI 春季新品发布会:全新GPT-4o模型详解

OpenAI 在其首次春季新品发布会上,于5月14日凌晨发布了全新的旗舰生成模型GPT-4o及相应的桌面应用程序,并展示了一系列令人瞩目的新技术能力。

发布会结束后,OpenAI的CEO Sam Altman 在社交平台X上发布了一个简短而神秘的词:

“her”,引发了广泛的猜测和讨论。

GPT-4o是什么?

GPT-4o(“o”代表“omni”全方位的)是一款革命性的多模态人工智能模型。它能够接收文本、音频和图像的任意组合作为输入,并生成文本、音频和图像的任意组合作为输出。GPT-4o能够在极短的232毫秒内响应音频输入,平均响应时间为320毫秒,与人类在对话中的响应时间相似。它在处理英语文本和编码任务上的表现与GPT-4 Turbo相当,在处理非英语语言文本上则有显著提升,同时API的响应速度更快,成本也降低了50%。相较于现有模型,GPT-4o在视觉和音频理解方面有着更出色的表现。

技术特点与升级

在GPT-4o之前的模型中,使用语音模式与ChatGPT交谈时存在显著的延迟问题,GPT-3.5的平均延迟为2.8秒,GPT-4则为5.4秒。之前的语音模式是一个由三个独立模型组成的管道:一个模型将音频转录为文本,GPT-3.5或GPT-4接收文本并输出文本,最后一个模型将文本转换回音频。这一过程导致大量信息丢失,如音调、多个说话者的声音或背景噪音等,也无法输出笑声、歌声或表达情感。

GPT-4o通过端到端地训练一个新模型,解决了这些问题。所有的输入和输出都由同一个神经网络处理,这意味着模型可以直接处理并理解音频和视频输入,大大提高了效率和准确性。这是OpenAI首次将文本、视觉和音频模式结合在一个模型中,虽然我们还只是在探索该模型的能力和局限性,但已经展示了巨大的潜力。

用户界面与平台支持

在用户界面方面,OpenAI推出了新的桌面版ChatGPT和更新的UI界面。这些新的界面和应用程序目前仅适用于macOS,但公司计划在今年晚些时候推出Windows版本。

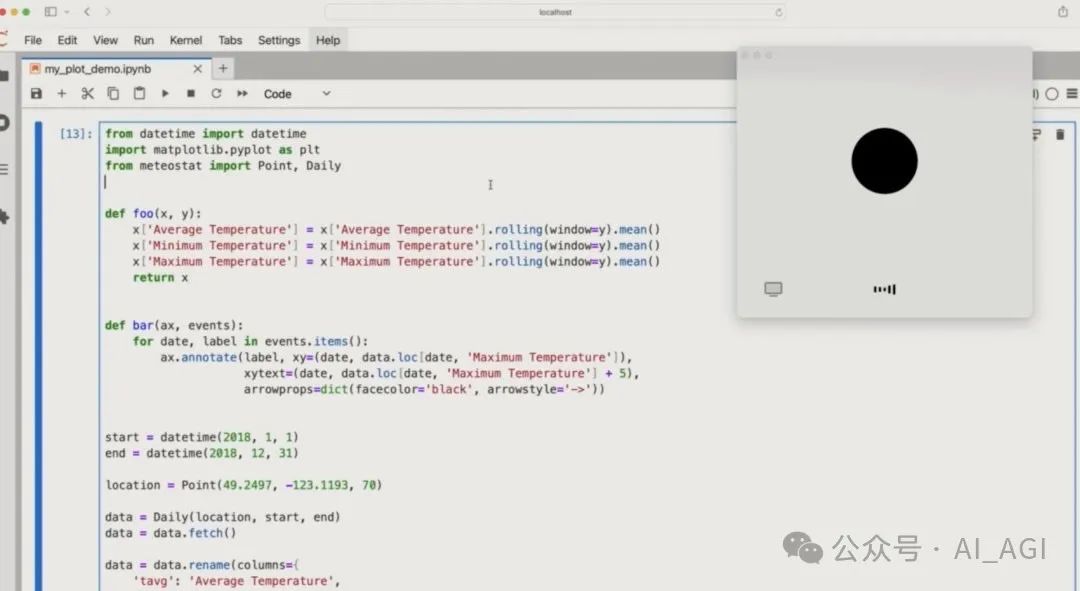

此外,据 @skirano 的消息,ChatGPT 桌面应用程序已经成为地球上最好的编码助手。只需选择代码,GPT-4o就能处理它。结合音频/视频功能,你就拥有了自己的工程师队友,这将极大地改善开发者的工作流程和效率。

模型功能

GPT-4o的设计考虑了语音模式中以往版本存在的延迟问题,严重影响了对话的沉浸感。新模型采用了一个全新的端到端训练模型,这意味着所有输入和输出都由同一个神经网络处理。这种设计不仅减少了信息丢失,还使得GPT-4o能够更好地理解和回应包括音调、多个说话者或背景噪音在内的复杂音频输入。

通过这些升级和改进,GPT-4o展示了OpenAI在推动AI技术前沿的持续努力和创新精神。它不仅为用户提供了更自然、更流畅的交互体验,还推动了AI技术在实时多模态交互方面的发展。

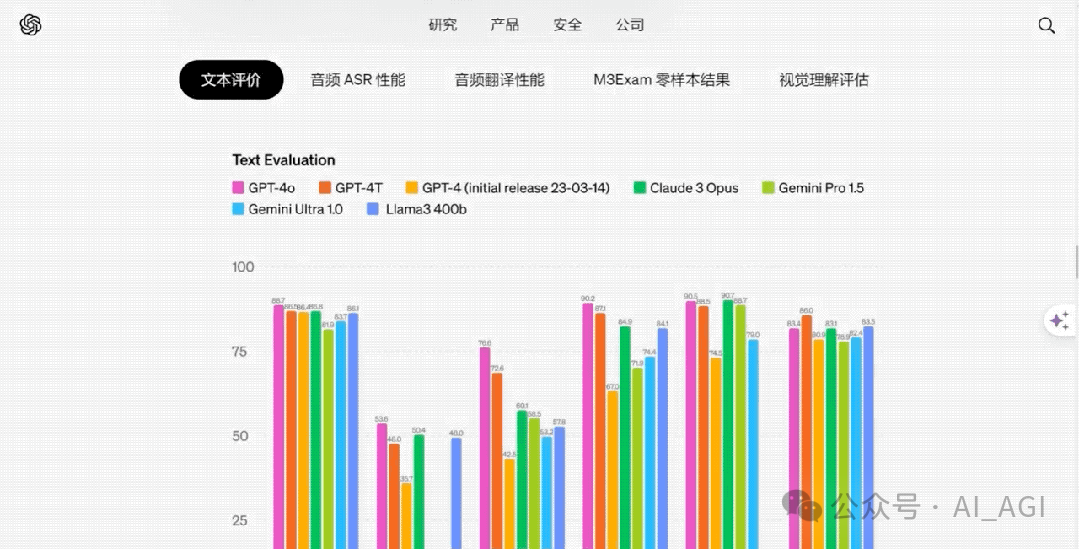

技术指标方面,使用粉红色标注的 GPT-4o 在文本能力方面领先市面上的所有模型,在音频视觉能力方 面得分也远超其他对手!

智能与实时响应是最大亮点

如同以往的发布会,OpenAI继续以展示其最新技术成就为主。此次,GPT-4o的亮点在于其能够实时处理跨越音频、视频和文本的复杂推理任务。GPT-4o能够接受任意组合的文本、音频和图像作为输入,并生成任意组合的文本、音频和图像输出,这一能力显著超越了以往的模型。

在实际演示中,GPT-4o展示了其多模态输入输出能力的实际应用场景。例如,ChatGPT语音助手能够用不同的声音、情绪和语调来阅读睡前故事,或是解答数学问题。观众可以看到,一个数学题被写在纸上,通过ChatGPT的视觉技术,GPT-4o能够阅读并解答这些问题。

演示中的一个亮点是,当OpenAI研究人员Mark Chen表示自己因为即将进行的演讲而感到紧张时,他询问GPT-4o是否有办法帮助他平静下来。作为回应,GPT-4o用幽默的方式回答:“Mark!你不是真空吸尘器。”这不仅展示了GPT-4o处理语音的速度,还展示了其理解和生成带有情感色彩的语言的能力。

对于GPT-4o的发布,SamAltman也在自己的博客发表了长篇文章,并表示 GPT-4o正在 接近人类的响应速度和表达能力,提高了人机交互体验。随着更多个性化功能的加入, GPT-4o将会引领令人期待的未来!

进ChatGPT群请加若飞,暗号 “gpt”